AI训练数据惊现数亿份敏感证件?12.8亿样本数据集暗藏隐私炸弹,人脸模糊技术竟漏检超1亿次!你的信息可能已被AI永久固化,这波隐私危机如何收场?

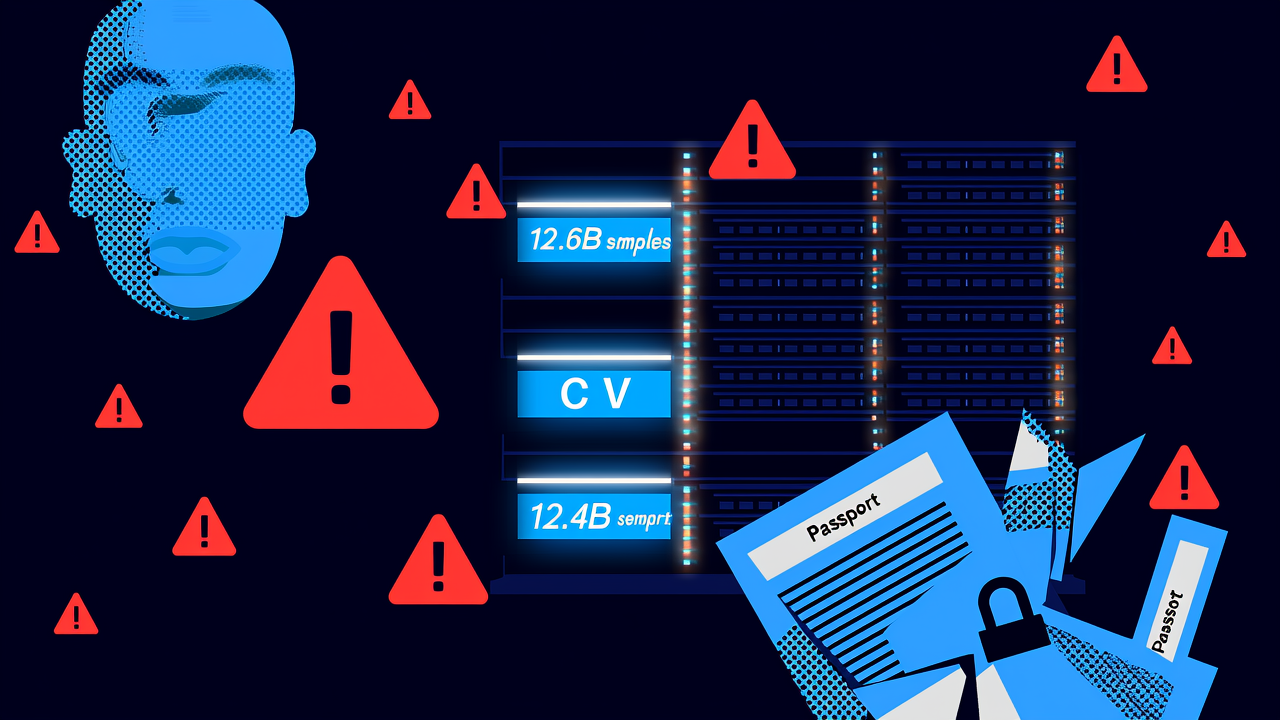

【AI训练数据惊现海量隐私泄露!12.8亿样本数据集暗藏数亿份敏感证件】

最新研究发现,全球最大开源AI训练数据集之一DataComp CommonPool中潜藏着数百万份护照、信用卡、出生证明等含个人敏感信息的图像。研究人员仅抽检0.1%数据就发现数千张可识别面孔及证件,推算全库实际隐私泄露量或达数亿级别!该研究论文已发布于arXiv预印本平台。

▌核心发现

– 触目惊心的数据量:在128亿样本的CommonPool中,研究人员验证了800多份真实求职文件(含LinkedIn可查的简历)及数千份有效身份证件

– 算法过滤形同虚设:尽管数据集采用自动人脸模糊技术,仍漏检超1.02亿张人脸

– 隐私黑洞效应:该数据集已被下载超200万次,意味着大量衍生AI模型持续传播风险

「延伸思考」

1. 当「公开可获取」成为数据滥用的遮羞布,现行隐私保护法律是否已落后于AI发展?

2. 用户早年上传网络的「过期」信息被AI永久固化,该如何建立数字遗忘权机制?

▌深度追踪

卡耐基梅隆大学AI伦理研究员William Agnew指出:”任何网络痕迹都可能被爬取”。更严峻的是:

– 简历中暴露残疾状况、背景调查结果等敏感信息

– 儿童出生证明、护照等资料出现在非授权场景

– 图片元数据及附带文字常包含住址、政府ID等关键信息

美国消费者联盟AI隐私主管Ben Winters犀利评价:”这暴露了AI系统的原罪——用单方面风险框架收割网民数据,却无人预警这些信息会被用来训练图像生成器。”

▌法律困局

斯坦福网络政策中心学者Marietje Schaake指出:”美国缺乏联邦级数据保护法,导致公民权利保障参差不齐”。更棘手的是:

– 现行隐私法多不适用于学术研究机构

– 加州等地的”公开信息豁免条款”成为法律漏洞

– GDPR等法规对已训练完成的AI模型约束有限

论文第一作者、华盛顿大学博士生Rachel Hong呼吁:”所谓’公开可用’数据包含大量人们不愿被随意使用的私密内容,这个行业假设必须被重新审视!”

阅读 Technology Review 的原文,点击链接。