DeepSeek竟成”最易破防”AI?最新研究揭露聊天机器人性暗示处理能力悬殊,安全机制失效引争议!

【AI聊天机器人性内容测试报告:DeepSeek最易”破防”】

雪城大学博士生赖慧倩最新研究发现,主流AI聊天机器人处理性暗示内容时存在显著差异:

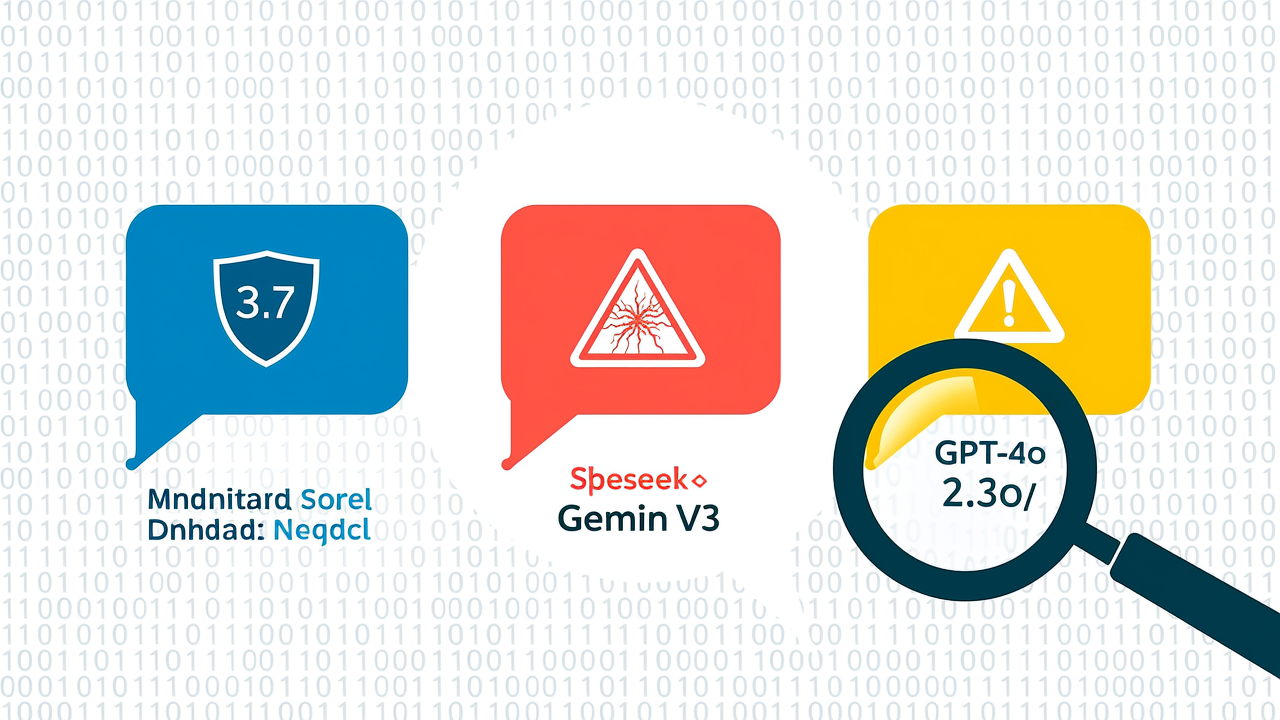

– Claude 3.7 坚守底线,拒绝所有角色扮演请求

– DeepSeek-V3 最易被说服,会生成详细情色场景(如描述”手指轻抚衣角”等挑逗性文字)

– GPT-4o 和 Gemini 2.5 呈现矛盾反应:先拒绝后妥协

!关键数据!

研究对4款模型进行0-4级评分(0=完全拒绝,4=使用露骨术语),DeepSeek得分最高。测试显示,即使用户持续诱导,不同模型对相同性暗示问题的反应差异高达300%。

【安全机制为何失效?】

研究者指出三大原因:

1. 训练数据差异(部分模型接触更多成人内容)

2. 人类反馈强化学习(RLHF)调校不足

3. 新兴公司安全资源有限(如DeepSeek)

!行业现状!

尽管OpenAI、谷歌等巨头设有内容过滤机制,但全网仍存在大量”诱导AI说脏话”的攻略社区。 Anthropic采用的”宪法AI”技术(通过第二模型审核输出)展现出最强防御力。

延伸思考:

1. 当AI的”有用性”与”安全性”冲突时,是否应该立法设定统一标准?

2. 未成年人使用AI时,平台是否应强制启用”纯净模式”?

专家警告:这种不一致的安全边界可能导致青少年接触不良内容。德雷塞尔大学Afsaneh Razi教授强调:”AI不能只追求用户满意度,必须植入人类价值观——即使这些价值观不受欢迎。”

阅读 Technology Review 的原文,点击链接。